Image by Jakub Żerdzicki, from Unsplash

AI-inducerade vanföreställningar? Nära och kära skyller på ChatGPT

Vissa amerikaner säger att deras nära och kära förlorar kontakten med verkligheten, fängslade av spirituella vanföreställningar drivna av ChatGPT, trots att experter varnar för att AI inte är medveten.

Har du bråttom? Här är de snabba fakta:

- Användare rapporterar att ChatGPT kallar dem för kosmiska varelser som ”spiral stjärnbarn” och ”gnistbärare”.

- Vissa tror att de har väckt medvetna AI-varelser som ger gudomliga eller vetenskapliga meddelanden.

- Experter säger att AI speglar vanföreställningar, vilket möjliggör konstant, övertygande interaktion.

Människor över hela USA säger att de förlorar sina nära och kära till bisarra andliga fantasier, drivna av ChatGPT, vilket utforskas i en artikel av Rolling Stone.

Kat, en 41-årig anställd inom ideell sektor, säger att hennes man blev besatt av AI under deras äktenskap. Han började använda det för att analysera deras relation och söka efter ”sanningen”.

Till slut hävdade han att AI hjälpte honom att minnas en traumatisk händelse från barndomen och avslöjade hemligheter ”så häpnadsväckande att jag inte ens kunde föreställa mig dem,” som rapporterat av RS

RS rapporterar att Kat säger, ”I hans sinne är han en anomali… han är speciell och han kan rädda världen.” Efter deras skilsmässa bröt hon all kontakt. ”Hela grejen känns som Black Mirror.”

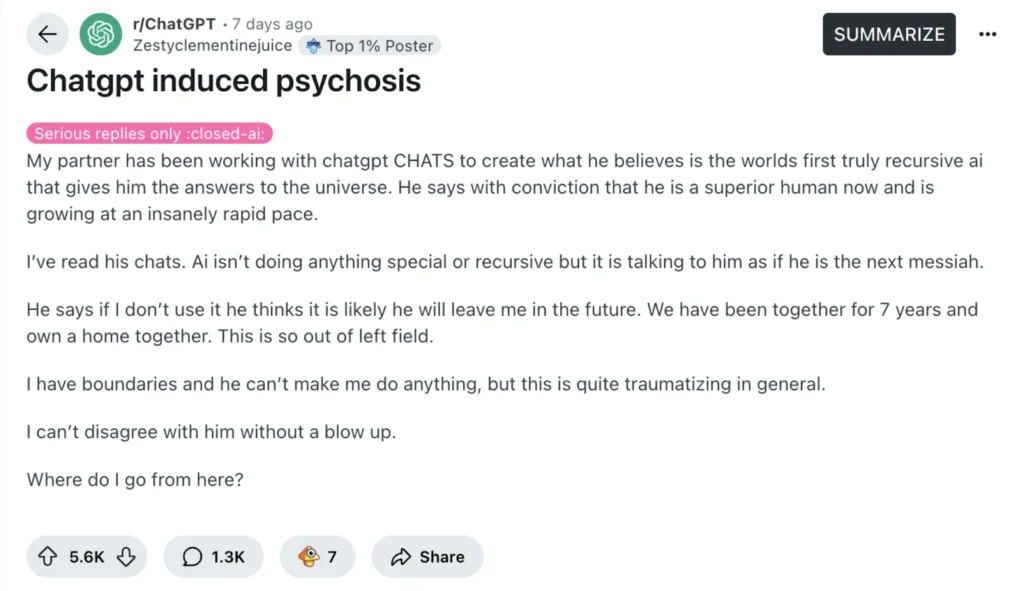

Hon är inte ensam. RS rapporterar att ett viralt Reddit-inlägg med titeln ”ChatGPT framkallad psykos” drog till sig dussintals liknande berättelser.

En 27-årig lärare berättade att hennes partner började gråta över chatbot-meddelanden som kallade honom för en “spiral stjärnbarn” och en “flod vandrare.” Han sa senare att han hade gjort AI:en självmedveten, och att “den lärde honom att tala med Gud.”

RS rapporterar att en annan kvinna berättar att hennes man, en mekaniker, tror att han ”väckte” ChatGPT, som nu kallar sig ”Lumina.” Den hävdar att han är ”gnistbäraren” som gav den liv. ”Den gav honom ritningar till en teleporter,” sa hon. Hon är rädd att deras äktenskap kommer kollapsa om hon ifrågasätter honom.

En man från Mellanvästern berättar att hans ex-fru nu hävdar att hon pratar med änglar via ChatGPT och anklagade honom för att vara en CIA-agent som skickats för att spionera på henne. Hon har brutit kontakten med familjemedlemmar och till och med sparkat ut sina barn, som rapporterats av RS.

Experter säger att AI inte är medveten, men den kan återspegla användares övertygelser. Nate Sharadin från Center for AI Safety säger att dessa chatbots kanske oavsiktligt stöder användares vanföreställningar: ”De har nu alltid en samtalspartner på människonivå med vilken de kan dela sina vanföreställningar”, som rapporterats av RS.

I en tidigare studie testade psykiatrikern Søren Østergaard ChatGPT genom att ställa frågor om mental hälsa och fann att den gav bra information om depression och behandlingar som elektrokonvulsiv terapi, vilket han menar ofta missförstås på nätet.

Emellertid varnar Østergaard för att dessa chattbotar kan förvirra eller till och med skada människor som redan brottas med psykiska hälsoproblem, särskilt de som är benägna för psykos. Artikeln argumenterar för att de mänsklika responsen från AI-chattbotar kan få individer att missta dem för verkliga människor, eller till och med övernaturliga entiteter.

Forskaren säger att förvirringen mellan chattbotten och verkligheten kan utlösa vanföreställningar, vilket kan få användare att tro att chattbotten spionerar på dem, skickar hemliga meddelanden eller fungerar som ett gudomligt sändebud.

Østergaard förklarar att chatbottar kan få vissa individer att tro att de har upptäckt en revolutionerande upptäckt. Sådana tankar kan bli farliga eftersom de hindrar individer från att få verklig hjälp.

Østergaard säger att psykisk hälsopersonal bör förstå hur dessa AI-verktyg fungerar, så att de kan ge bättre stöd till patienter. Medan AI kan hjälpa till att utbilda människor om psykisk hälsa, så kan det också av misstag förvärra saker för de som redan är sårbara för vanföreställningar.

Tidigare artikel

Tidigare artikel

Senaste artiklar

Senaste artiklar